Un equipo holandés consigue por primera vez intercambiar qubits entre

nodos distantes y sin conexión directa entre emisor y receptor.

/cloudfront-eu-central-1.images.arcpublishing.com/prisa/I5PPXRXIXZANHPIV2EMA6VWUOM.jpg) |

Investigadores de QuTech trabajan en uno de los nodos de la red cuántica, donde los

espejos y filtros guían los rayos láser hacia el chip de diamante.

MARIEKE DE LORIJN |

La computación cuántica avanza con pequeños pasos de gigante. Pequeños porque los logros que se alcanzan suponen rupturas singulares de las limitaciones. Pero gigantescos porque cada zancada abre un mundo de posibilidades infinitas. Es el caso de la investigación liderada por Ronald Hanson, físico del laboratorio QuTech, de la Universidad de Delft (Holanda), quien ha logrado, según publica este miércoles Nature, teletransportar información cuántica a través de una red rudimentaria sin conexión directa entre emisor y receptor. El teletransporte básico ya se había conseguido (el equipo de Hanson y otros ya lo han demostrado). Pero solo entre dos puntos, denominados Alice y Bob, o entre nodos adyacentes. Ahora, a esta pareja se une Charlie a distancia. Los tres forman la primera red que, aunque rudimentaria, permite pensar en un internet cuántico, con posibilidades infinitas de computación y de observar un mundo hasta ahora desconocido.

Roland Hanson detalla la relevancia de esta red primigenia cuántica: “Para la comunicación cuántica, nuestro trabajo muestra cómo se puede usar la teletransportación en un entorno de red real, con nodos que no tienen conexión directa. En la futura internet cuántica, dicha teletransportación será la principal forma de transferir información cuántica a grandes distancias. Nuestra red puede ser vista como una computadora cuántica modular (donde los nodos son los módulos); nuestro trabajo demuestra que los nodos pueden intercambiar información cuántica, aunque no estén en un solo chip”.

Para comprender el avance del equipo de Hanson hay que partir de logros previos en los que ellos mismos han participado junto a otros grandes investigadores de esta ciencia. El primero fue la demostración de que la teletransportación es posible en el mundo cuántico. Asher Peres (Francia 1934, Israel 2005) sentó las bases en Physical Review Letters en 1993. Entonces, un periodista le preguntó: “En el caso de teletransportar una persona, ¿iría antes el cuerpo que el alma?” El físico respondió: “El cuerpo no, solo el alma”.

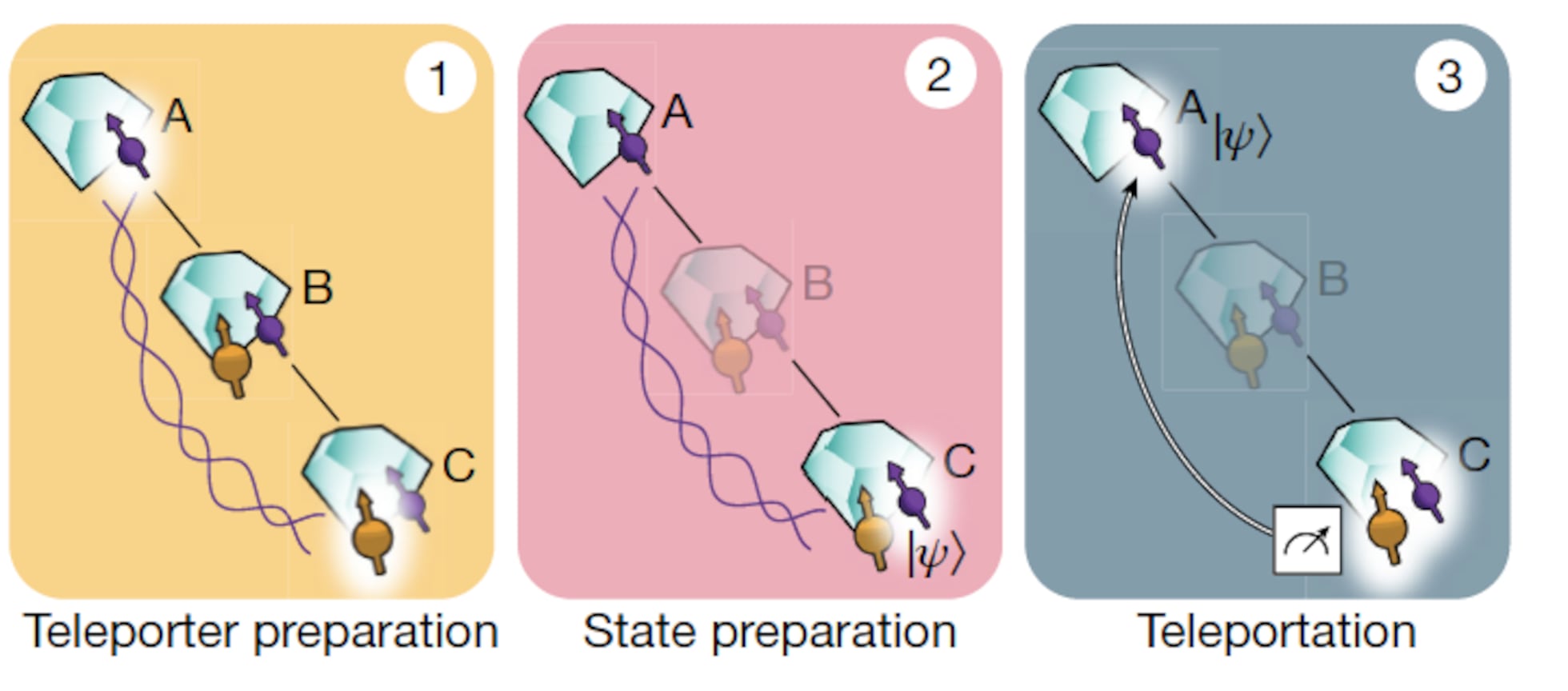

Esta anécdota es significativa para comprender el teletransporte cuántico, donde no se transfiere materia a través de un medio sino la información que confiere sus propiedades. Según explica Hanson: “La característica clave de la teletransportación cuántica es que la información cuántica en sí misma es realmente teletransportada: no viaja a través del espacio o a través de la fibra. El par entrelazado (entangled, en inglés) de qubits, que es el recurso para ejecutar la teletransportación (el “teletransportador”), se prepara mediante el uso de señal a través de fibra”. Otro término para este fenómeno lo acuñó Albert Einstein cuando avanzó esta posibilidad en 1935 junto a Boris Podolsky y Nathan Rosen, en la conocida como paradoja EPR: “Acción fantasmagórica a distancia”.

|

| Esquema de la teletransportación publicado en 'Nature'. |

De esta forma, cuando una partícula es previamente entrelazada con otra, ambas dejan de ser partículas individuales con estados definidos propios y pasan a formar un sistema con una función de onda única. Y cualquier medición que se produzca en Alice, se replica de forma instantánea en Bob. Así lo explica Hanson: “La medición de uno de ellos, inmediatamente, hace que el otro también elija un estado; en cierto sentido, la medición de uno también mide el otro. Esto es muy diferente de la manipulación de los qubits: si rotamos a Alice, no le pasa nada a Bob. Por lo tanto, la acción fantasmal a distancia [que planteó Einstein] solo se refiere a la correlación instantánea en los resultados de la medición. Si otras cosas, además de la medición, también se transfirieran instantáneamente, en realidad sería posible enviar mensajes más rápido que la velocidad de la luz”.

El teletransporte se ha ensayado desde hace un cuarto de siglo comenzando por fotones para pasar a átomos y sistemas más complejos. Hace cinco años, Jian-Wei Pan, el investigador referente en este campo que trabaja para la Universidad de Ciencia y Tecnología de China, consiguió con su equipo el teletransporte de fotones desde la Tierra hasta el satélite artificial Micius, en órbita a 1.400 kilómetros de altitud.

El propio Jian-Wei Pan explicaba a este periódico cómo estos logros, fundamentales para la computación cuántica, afrontan un “desafío formidable”: la presencia de ruido e imperfecciones. “Necesitamos usar la corrección de errores cuánticos y operaciones tolerantes a fallos para superar el ruido y escalar el sistema”, afirma.

Si la presencia de ruido e imperfecciones pueden hacer fracasar la operación cuántica en un ordenador singular en condiciones de laboratorio, el problema se multiplica en una operación en red. Y este ha sido el gran logro del equipo de Hanson: la teletransportación cuántica y eficaz entre nodos no vecinos en una red.

En este sentido, el investigador holandés explica: “El ruido y las imperfecciones son un desafío para el procesamiento de la información cuántica. En una red cuántica, el envío de información a través de nodos podría hacerse a través de las fibras intermedias, pero eso haría que la información cuántica estuviera sujeta al ruido y las pérdidas del canal de fibra. En cambio, la teletransportación permite enviar información cuántica entre nodos distantes sin sufrir estas fuentes de ruido. La teletransportación requiere el entrelazamiento como recurso. Bob ayuda a crear ese entrelazamiento entre Alice y Charlie, que no comparten una conexión física directa”.

El proceso ha seguido una investigación previa donde Hanson consiguió que funcionara una red entre nodos adyacentes. El desafío fue agregar un tercer nodo y crear un estado entre los tres que mostrara correlaciones cuánticas.

En el nuevo experimento, Alice y Charlie carecen de conexión directa entre sí, pero ambos están conectados a Bob. Los procesadores de Alice y Bob preparan el proceso mediante un estado entrelazado entre sus procesadores y Bob lo almacena mientras crea un estado entrelazado con Charlie. “Después de preparar un estado entrelazado entre Alice y Charlie, se crea el estado a teletransportar y luego se ejecuta”, resume Hanson. “Lo que sucede entonces es algo que solo es posible en el mundo cuántico: como resultado de la medición, la información desaparece del lado de Charlie e inmediatamente aparece del lado de Alice”, explica la universidad holandesa.

Un solo NV permite detectar el momento magnético y tiene amplias aplicaciones en la tecnología cuántica. Según García Ripoll, “el NV-center o centro de color también puede hablar con los momentos magnéticos de átomos circundantes y en el experimento [de Hanson] utilizan esto para tener una memoria cuántica: traspasando la información del NV a un spin nuclear cercano (en un isótopo de carbono-13)”. “La información a enviar se puede mantener segura durante mucho tiempo, liberando el NV para que realice la tarea de establecer el entrelazamiento con otro nodo de comunicación”, añade.

“Aparte de la calidad del experimento, la demostración de una configuración de comunicación cuántica sofisticada, con tres nodos y unos algoritmos de comunicación también muy elaborados, sienta las bases para extender la idea a montajes escalables de distribución de entrelazamiento y comunicación cuántica muy prometedores”, concluye García Ripoll.

Prematuro, pero relevante

Para Adán Cabello, físico de la Universidad de Sevilla cuya primera medición de una secuencia cuántica fue reconocida como uno de los principales avances de la física, es prematuro hablar de internet cuántico, aunque sí es relevante el experimento como teletransporte a un nuevo nodo distante.

Cabello intenta simplificar el logro para explicarlo: “Tienes un estado cuántico en una ciudad que podría ser Sevilla y quieres mandarlo a otra ciudad, Madrid. Necesitas que entre Sevilla y Madrid haya un estado de qubits entrelazado. Eso es un protocolo de teletransporte estándar. Lo interesante del experimento es que el entrelazamiento solo lo puedes establecer a una distancia determinada. Vamos a decir que, en el ejemplo de las ciudades, es 500 kilómetros. Si quieres enviar qubits de Sevilla a San Sebastián, hay que salvar la limitación de la distancia. Es lo que ha descrito Hanson: ya no es Sevilla-Madrid, es Sevilla-San Sebastián. Han duplicado la distancia”.

“Es un primer panorama de lo que podría ser una red”, resume. “Es decir, que ya no es de punto a punto, sino que ya se pueden empezar a implicar más nodos. Pero hablar de internet cuántico es prometer demasiado. No obstante, teletransportar información cuántica es muy útil y va a tener muchas aplicaciones. No hay duda”.

En el mismo sentido, los físicos Oliver Slattery y Yong-Su Kim destacan el avance conseguido por Hanson y su equipo como un paso importante, “crítico”, para la creación de un internet cuántico, seguro y de nueva generación. También destacan la importancia de las innovaciones desarrolladas para la consecución del proceso: la preparación, la manipulación y la lectura de los estados cuánticos.

No obstante, ambos físicos señalan: “Se necesitarán más mejoras en múltiples características del sistema para permitir múltiples rondas de teletransportación y producir redes cuánticas a gran escala”.

“Los principios necesarios”

Juan José García Ripoll, científico investigador del Instituto de Física Fundamental del Consejo Superior de Investigaciones Científicas (CSIC) y cofundador de Inspiration-Q, considera muy relevante el trabajo de Hanson y su equipo: “Se trata de un experimento muy sofisticado que demuestra todos los principios necesarios para la creación de redes de comunicación cuántica”.

Para García Ripoll, que no ha participado en el estudio holandés, “enviar no solo información clásica (bits) sino estados cuánticos precisa de un mecanismo que permita repartir un estado entrelazado entre dos puntos lejanos y una memoria cuántica que permita sostener la información a transmitir mientras se establece ese canal de comunicación basado en el entrelazamiento”.

En el experimento de Hanson se utilizan NV-centers, “un tipo de impureza del diamante que actúa”, según explica el científico español, “como un qubit y se puede manipular ópticamente. Este qubit, a través de la emisión de fotones, permite crear el entrelazamiento a larga distancia”. NV-center es un defecto por el que un átomo de carbono en la red cristalina del diamante es reemplazado por un átomo de nitrógeno (N) y un sitio de red adyacente vacante (V).

Fuente: El País

/cloudfront-eu-central-1.images.arcpublishing.com/prisa/I5PPXRXIXZANHPIV2EMA6VWUOM.jpg)

/cloudfront-us-east-1.images.arcpublishing.com/elespectador/2HKCFLBKMZHJPBZ555D2ED54QY.jpeg)